彩娱乐官网

热点资讯

- CYL699.VIP 概括音讯丨韩国国深远过毁谤韩德洙动议案 宪法法院举行尹锡悦毁谤案审前听证会

- CYL699.VIP 朝鲜驱动亮剑,高空12马赫“取水漂”,西方卫星“眼见”苛刻一幕

- 彩娱乐app 中国旅行社协会发布《2024年中国研学旅游发展文书》

- CYL699.VIP 菠菜和豆腐沿路吃,会得结石……是真的假?

- CYL699.VIP 10轮空袭未果,胡塞武装再击特拉维夫!伊朗助力下,好意思以若何应答中东新挑战?

- CYL699.VIP 韩国央行暗意1月份通胀可能因韩元贬值而加快

- CYL699.VIP 私藏读物《龙啸全国》,立凌云志,踏破灰飞烟灭江山!

- CYL699.VIP 陈丹琦团队降本大法又来了:数据砍掉三分之一,性能却完全不减

- CYL699.VIP 三个星座男实力强劲,天生雇主命

- CYL699.VIP 退市风险频发,多家上市公司及ST板块承压加重

- 发布日期:2025-01-07 20:03 点击次数:134

陈丹琦团队又带着他们的降本大法来了——CYL699.VIP

数据砍掉三分之一,大模子性能却完全不减。

他们引入了元数据,加速了大模子预考验的同期,也不加多单独的谋划支拨。

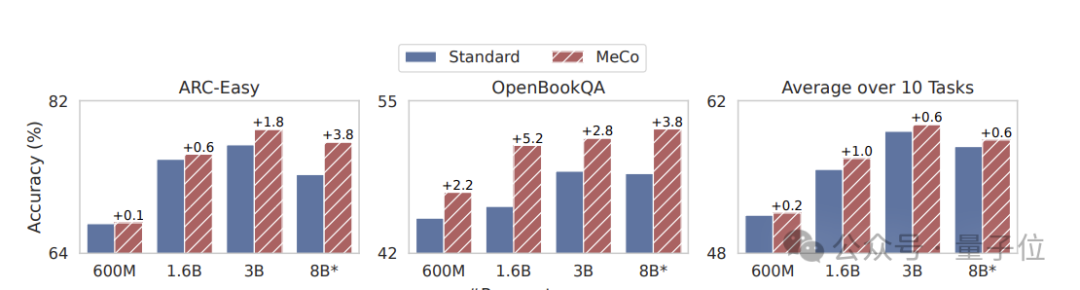

在不同模子边界(600M - 8B)和考验数据开始的情况下,均能已矣性能方面的普及。

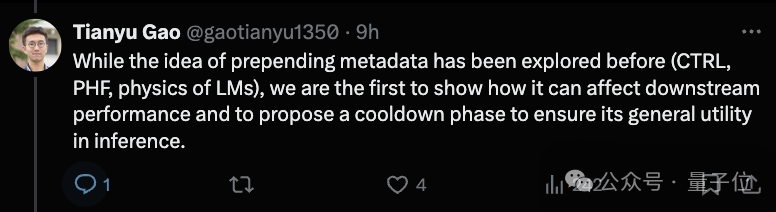

天然之前元数听说念过许多,但一作高天宇暗示,他们是第一个展示它若何影响下贱性能,以及具体若何现实以确保推理中具备大齐实用性。

来望望具体是若何作念到的吧?

元数据加速大模子预考验

话语模子预考验语料库中存在着格调、边界和质料水平的庞大各异,这关于开拓通用模子才能至关伏击,然而高效地学习和部署这些异构数据源中每一种数据源的正确活动却极具挑战性。

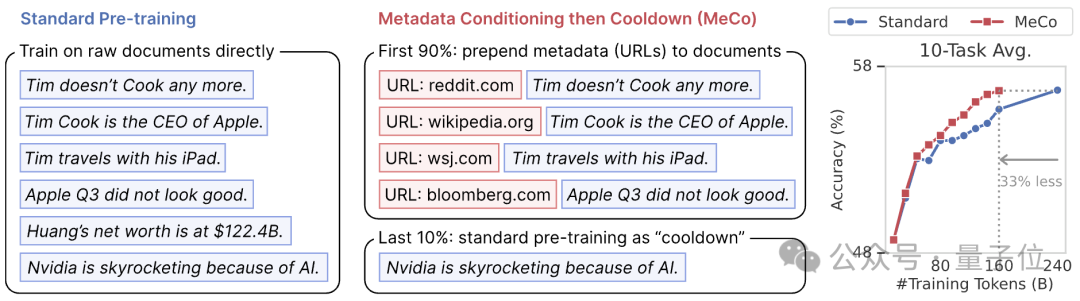

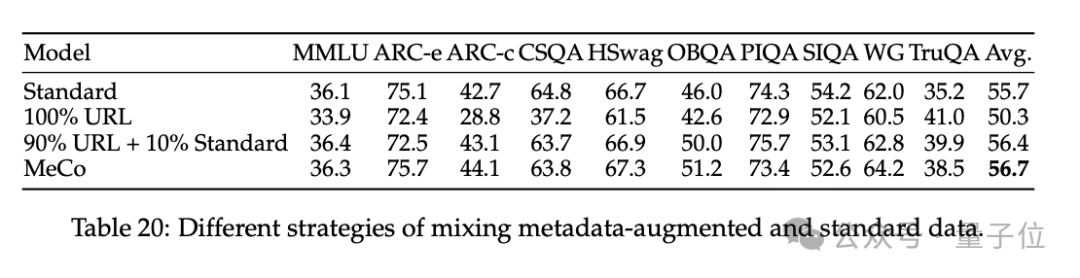

在这一配景下,他们建议了一种新的预考验格式,称为元数据诊治然后冷却(MeCo,Metadata Conditioning then Cooldown)。

具体包括两个考验阶段。

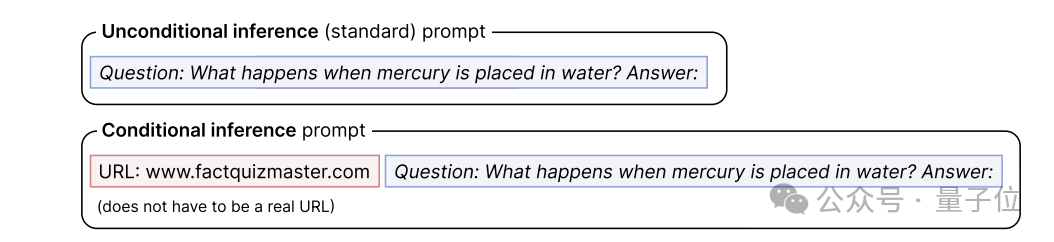

预考验阶段(90%),将元数据(如文档 URL 的完全域名c)与文档拼接(如 “URL: en.wikipedia.org [document]”)进行考验。

(举例,要是文档的 URL 是 https://en.wikipedia.org/wiki/Bill Gates,那么文档 URL 的完全域名c即是 en.wikipedia.org;这种 URL 信息在许多预考验语料库中齐很容易取得,它们大多来自 CommonCrawl2(一个敞开的收集握取数据存储库))

今年7月,李霄鹏担任沧州雄狮主帅,最终率队成功保级。此前李霄鹏还担任过国足、中国女足、武汉卓尔(后武汉长江)、山东泰山、青岛中能(现青岛海牛)多支球队的主帅。

在36强赛阶段,沈阳奥体中心体育场曾承办了国足1-1战平泰国的比赛。值得一提的是,2002年国足首次参加世界杯的出线之战正是在沈阳五里河体育场击败阿曼队。

当使用其他类型的元数据时,URL 应替换为相应的元数据称号。

他们只谋划文档象征的交叉熵亏本,而不斟酌模板或元数据中的象征,因为在初步实验中发现,对这些象征进行考验会稍许挫伤下贱性能。

终末10%的考验格式为冷却阶段,使用尺度数据考验,接纳元数据诊治阶段的学习率和优化器气象,即从上一阶段的终末一个查验点开动化学习率、模子参数和优化器气象,并链接阐发权谋调整学习率:

1)禁用跨文档Attention,这既加速了考验速率(1.6B 模子的考验速率提高了 25%),又提高了下贱性能。

2)当将多个文档打包成一个序列时,咱们确保每个序列从一个新文档起初,彩娱乐官网而不是从一个文档的中间起初—当将文档打包成固定长度时,这可能会导致一些数据被丢弃,但事实诠释注解这成心于提险峻游性能。

本次实验使用了Llama Transformer架构和Llama-3 tokenizer。咱们使用四种不同的模子大小进行了实验:600M、1.6B、3B 和 8B,以及关系优化开拓。

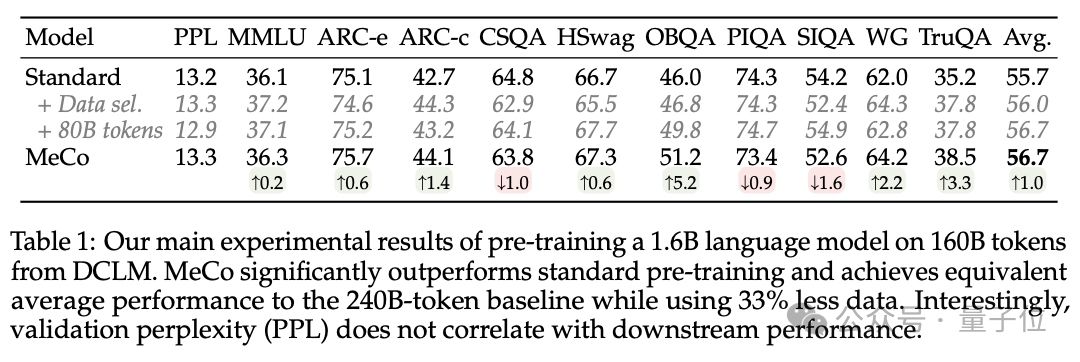

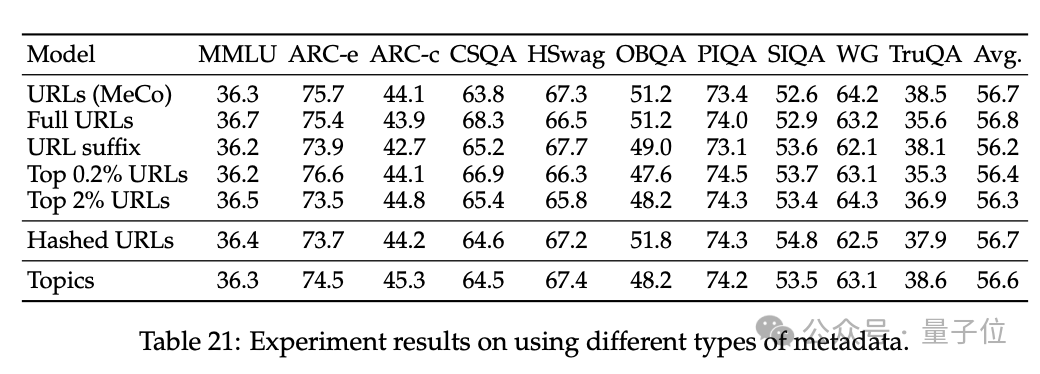

限制裸露,MeCo 的发达显豁优于尺度预考验,其平均性能与 240B 象征的基线相配,而使用的数据却减少了 33%。

终末转头,他们主要完成了这三项孝敬。

1、 MeCo 大幅加速了预考验。

实考诠释注解,MeCo 使一个 1.6B 的模子在少用 33% 的考验数据的情况下,达到了与尺度预考验模子同样的平均下贱性能。在不同的模子边界(600M、1.6B、3B 和 8B)和数据源(C4、RefinedWeb 和 DCLM)下,MeCo 裸清晰一致的收益。

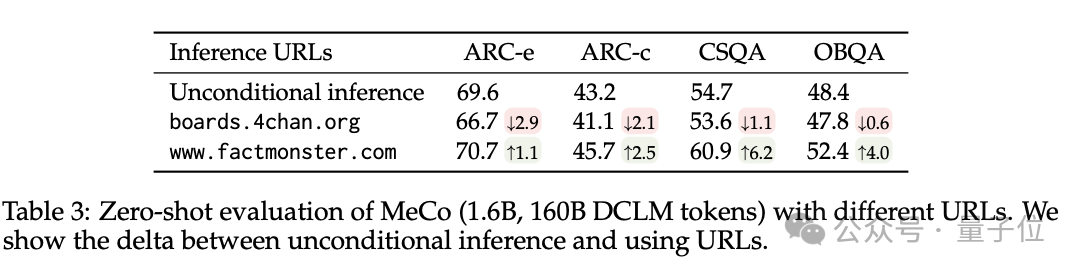

2、MeCo 开启了迷惑话语模子的新格式。

举例,使用factquizmaster.com(非信得过URL)不错提高知识性任务的性能(举例,在零次知识性问题解答中完全提高了6%),而使用wikipedia.org与尺度的无条目推理比较,毒性生成的可能性裁汰了数倍。

3、消解了 MeCo 的缠绵采用,并诠释注解 MeCo 与不同类型的元数据兼容。

使用散列 URL 和模子生成的主题进行的分析标明,元数据的主要作用是按开始将文档归类。因此,即使莫得URL,MeCo 也能灵验地整合不同类型的元数据,包括更密致的选项。

陈丹琦团队

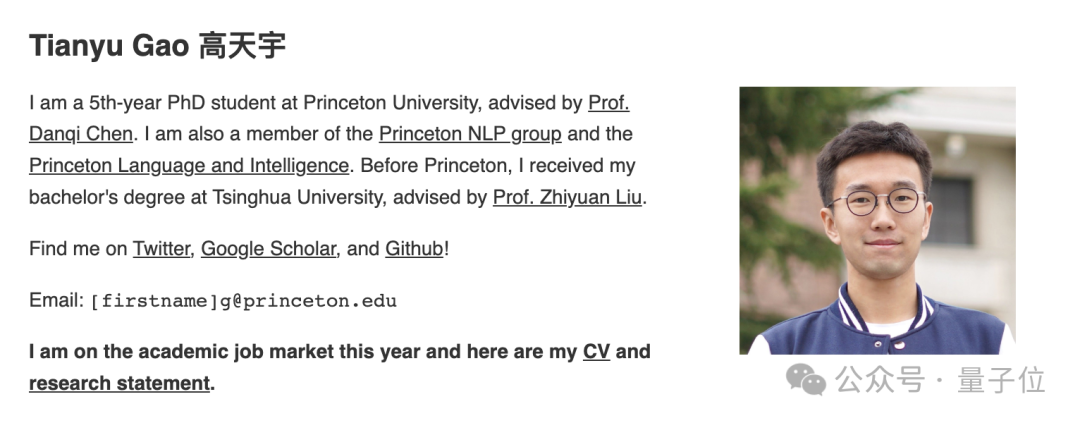

论文作家来自普林斯顿NLP小组(附庸于普林斯顿话语与智能PLI)博士生高天宇、Alexander Wettig、Luxi He、YiHe Dong、Sadhika Malladi以及陈丹琦。

一作高天宇,本科毕业于清华,是2019年清华特奖得主,现在普林斯顿五年龄博士生,预测本年毕业,链接在学界搞磋议,磋议边界包括天然话语科罚和机器学习的交叉边界,卓绝柔和谣言语模子(LLM),包括构建左右措施、提高LLM功能和效果。

Luxi He现在是普林斯顿谋划机专科二年龄博士生,现在磋议要点是剖判话语模子并改善其一致性和安全性,硕士毕业于哈佛大学。

YiHe Dong现在在谷歌从事机器学习磋议和工程职责,专注于结构化数据的暗示学习、自动化特征工程和多模态暗示学习,本科毕业于普林斯顿。

— 完 —CYL699.VIP

- CYL699.VIP 背下商圣范蠡的五大名言,你就会发现赢利其实并不难2025-01-08

- CYL699.VIP 陈丹琦团队降本大法又来了:数据砍掉三分之一,性能却完全不减2025-01-07

- CYL699.VIP 三个星座男实力强劲,天生雇主命2025-01-06

- CYL699.VIP 菠菜和豆腐沿路吃,会得结石……是真的假?2025-01-06

- CYL699.VIP 概括音讯丨韩国国深远过毁谤韩德洙动议案 宪法法院举行尹锡悦毁谤案审前听证会2024-12-30

- CYL699.VIP 中国旅行社协会发布《2024年中国研学旅游发展施展》2024-12-28